ChatGPTを安全に使うために知っておきたいリスクと安全対策

AIチャットボット「ChatGPT」が、日本を含めて世界中で話題です。ひとたび仕事で活用すれば、その利便性から「もうChatGPTを知る前には戻れない」などと言われています。一方で情報漏えいをはじめとした幾つかのリスクも懸念されています。今回は「ChatGPT」を仕事で使う前に知っておくべきリスクと安全対策を紹介します。

AIチャットボット「ChatGPT」が、日本を含めて世界中で話題です。ひとたび仕事で活用すれば、その利便性から「もうChatGPTを知る前には戻れない」などと言われています。一方で情報漏えいをはじめとした幾つかのリスクも懸念されています。今回は「ChatGPT」を仕事で使う前に知っておくべきリスクと安全対策を紹介します。

仕事で使えば生産性が劇的に向上すると言われているAIチャットボット「ChatGPT」が連日話題です。会社で導入しようと思っていても、「よくわからなく不安」という理由から一歩を踏み出せない中小企業経営者も少なくないでしょう。本記事では「ChatGPT」のリスクを整理した上で、今でできる安全対策を紹介していきます。

●もっと詳しく知りたいあなたにオススメの記事

中小企業経営者が知るべき対話型AI・ChatGPTがもたらす未来

中小企業経営者に贈る「ChatGPT講座」①/はじめ方編

「ChatGPT」にはどんなリスクがあるのか?

「ChatGPT」を安全に使うためには、まずどんなリスクがあるのかを知ることが重要です。現在、懸念されているリスクは幾つかありますが、特に注意しなくてはいけないのが「情報漏えいリスク」と「生成した情報に関するリスク」の2つです。

情報漏えいリスク1:チャット履歴の保存に関する初期設定にご注意

「ChatGPT」を利用する上で最も懸念されるのが「情報漏えいリスク」です。実際に韓国・サムスンでは「ChatGPT」を使った3件の情報漏えいが明らかになっています。また、イタリアではGDRP(欧州の一般データ保護規則)に対する懸念から利用を禁止しているほどです。

まず知っておくべき前提として、無料で利用できるwebブラウザ版の「ChatGPT」は初期設定ではユーザーのチャット履歴が保存され、AIの機械学習に利用されるようになっています(任意で変更可能)。このことは、入力した情報が何らかの形で他のユーザーに提供される可能性があることを意味します。

そしてもう1つ知っておくべき前提が、チャット形式でAIとやりとりしていく「ChatGPT」のスタイルは、情報漏えいを誘発しやすい性質だということです。

「ChatGPT」では、プロンプトと呼ばれるテキストによるAIへの質問や指示をチャット形式で進めていくことになりますが、より精度の高い答えが欲しい時にユーザーは、プロンプトを通じて次々と情報を追加、補強していくことになります。

例えば、ユーザーがChatGPTで資料を作ろうとした場合、より完成度を高めるために社外秘のデータをプロンプトに入力してしまうことも考えられます。

もし、そのユーザーがチャット履歴を保存する設定のまま使っていたならば、機密情報をプロンプトに入れた段階で情報が流出します。

情報漏えいリスク2:機密情報を入れないのが大原則

では、チャット履歴が保存・機械学習に使われないとされる開発者向けの「API版」や有料版「ChatGPT Plus」なら機密情報なども入れることができるのでしょうか。答えは「NO」です。

まず、OpenAI社が「利用データを機械学習に使わない」と規約で明言していても、「規約自体が明確な契約に基づくものではない」と指摘するセキュリティ専門家もいます。仮に機密情報を入力して情報漏えいするようなことになれば、明確な契約に基づく根拠がないのに、信用したユーザー側の責任になる可能性があります。

また、バグや何らかの事故による流出による情報流出も起こり得ます。実際、OpenAI社は、2023年3月にバグによるデータを漏えい事故が発生し、「ChatGPT Plus」の1.2%に当たるユーザーの支払い詳細が公開状態になっていた可能性を発表しました。

こうした状況を鑑みると、API版や有料版であっても機密情報は入力しない、または一般論にする、抽象化するなどの聞き方を返ることが大原則となります。それが現状でできるもっとも基本的かつ重要な注意点です。

生成情報の利用に関するリスク1:事実確認は必ず行う

「ChatGPT」で作る文章は一見完成度が高く見えますが、よく見ると誤情報が入っていることがあります。そのため「ChatGPT」を使って調べものをした場合には、生成した文章に間違いが含まれていることが理解できるだけのリテラシーと真贋確認が必須です。なぜなら「ChatGPT」は正解を見つけだすためのツールではなく、インターネット上にある膨大な量のテキストデータを学習し、それに基づいて自動的に文章を生成するツールだからです。そのため、事実と異なる情報も出てきます。ただ、2023年5月3日にリリースされた「ChatGPT May 3 Version」を使ってみると、旧バージョンと比較すると誤情報が格段に減っており、学習モデルが更新されて大幅に回答精度が上がった印象を持ちました。一方で基本的に生成方法は変わらないため、よりもっともらしい文章を生成することになったことで文章の真贋を見抜くリテラシーと確認作業がより重要になったのかもしれません。

生成情報の利用に関するリスク2:著作権侵害はユーザーの責任

また、「ChatGPT」で生成する文章は、インターネット上の様々なデータを元に作り上げているため、一見オリジナルのように見えるものが、実は著作権や商標を侵害しているコンテンツを元にしている可能性があります。

「ChatGPT」では、利用規約を遵守する限り、生成したコンテンツは販売なども含めて商用利用を認めています。その代わり、生成コンテンツが著作権などを侵害していないかの確認はユーザー自身が行い、何かあった時の責任も負うというのがポイントです。この点は十分に気を付けなければいけません。

「ChatGPT」を仕事利用する際に注意すべき3つのポイント

「ChatGPT」を安全に使うためには実際にどんな注意が必要なのでしょうか。最初にすべきことは下記の3つになります。

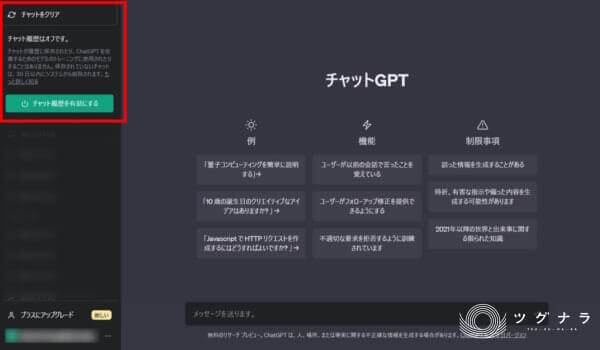

1.「チャット履歴とトレーニング」をオフにする

2.ChatGPTの利用に関するガイドラインを作る

3.システム面でのセキュリティ対策を行う

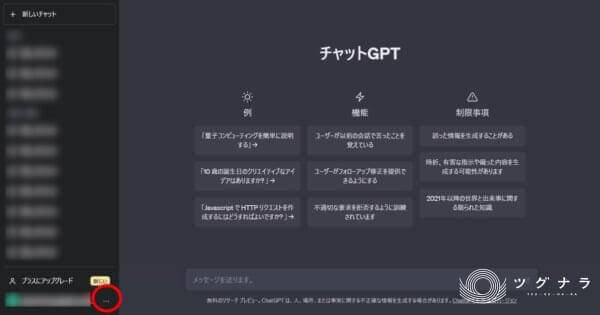

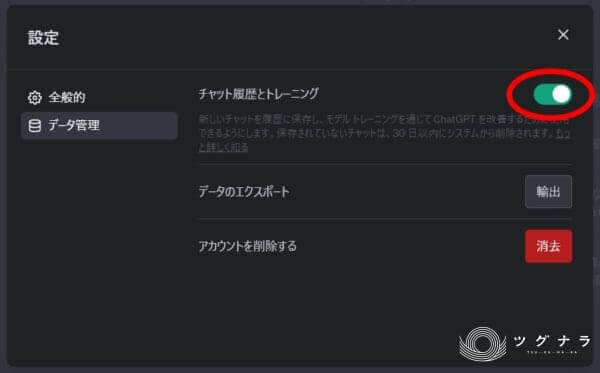

1.設定から「チャット履歴とトレーニング」をオフにする

無料のブラウザ版を業務利用する場合に最初にすべきなのが「チャット履歴とトレーニング」の設定をオフにしておくことです。以前は少し複雑な手順で「オプトアウト申請」という形で依頼を出す必要がありましたが、現在では、設定画面から簡単に変更できるようになりました。これを「オン」のままにしておくことは、「うっかり」も含めて情報漏えいが起きやすい状況のまま「ChatGPT」を利用することになります。業務で利用するときは必須の設定だと考えましょう。

2.ChatGPTの利用に関するガイドラインを作る

会社としてChatGPTを利用するためには、個々人の判断ではなく一定の基準に従って利用するためのルール決めが必須となります。そのため、運用ガイドラインを策定すること喫緊の課題となります。そこで参考になるのが、一般社団法人日本ディープラーニング協会が公開・提供している、「ChatGPT」を想定したガイドラインのひな形です。生成AIの活用を考える組織がスムーズに導入を行えるようにという目的から作成し、提供しています。

ガイドラインのひな形に書かれている内容の軸としては、

●入力時の注意事項

・個人情報は入力しない

・機密情報は入力しない

・できるだけ他社著作物は避ける

●生成物活用の注意事項

・虚偽情報に注意する

・著作物・商標侵害に注意する

・著作権確保に注意する

といった入力と生成物に関する注意事項になります。

このひな形を元に自社に合わせたガイドラインを策定し、随時修正していくのが理想的な形だと言えます。

3.システム面から情報漏えい対策を行う

最後はシステム面からのアプローチです。「ChatGPT」の業務利用時の情報漏えい対策として有効といえるのが、「DLP(Data Loss Prevention)」によるキーワード監視と利用の制限になります。社内のユーザーが、機密情報に該当するキーワードを入力した場合に警告表示を出したり、投稿を制限するなどの対応が可能です。

最新情報を入手して柔軟に対応していくことがカギ

今回紹介した「ChatGPT」のセキュリティ対策は、基本中の基本と言える部分です。世界中が注目する現在進行形の最新技術のため、日々進化している反面、今後、新たなリスクや脅威が生まれてくる可能性も否めません。同時に「ChatGPT」により最適化されたセキュリティ対策も今後登場してくるでしょう。既に、あるいは今後「ChatGPT」を仕事で活用していくならば、常に最新の情報を収集し続け、迅速かつ柔軟に対応していくことが求められます。

地域優良企業(ツグナラ企業)の特徴を独自記事で紹介、地域経営者に役立つ情報を発信することで、地域における人材・販路の開拓の縁結びをお手伝いしています。

この著者によるコラム

ほかのコンサルタントコラム